La complexité des nouveaux systèmes d’énergie nécessite une nouvelle approche des données et de nouveaux outils. SenX propose une plateforme neutre basée sur les Séries Temporelles.

Depuis qu’elle existe, l’informatique a toujours tenu une place particulière chez les grands acteurs de l’énergie et, en particulier, de l’électricité. L’émergence et l’expansion progressive des réseaux intelligents (Smart Grids) bouleverse aujourd'hui des schémas établis avec en perspective un triptyque plein de promesses : données, énergie et intelligence artificielle.

Hormis quelques références à l’énergie au sens large, cet article traite avant tout d’électricité. Comme aime à le rappeler Jean-Marc Jancovici, elle ne représente que 37% de l’énergie finale consommée.

| Cet article s’inscrit dans une série engagée sur le thème éponyme du premier d’entre eux : « Les séries temporelles : le futur de la donnée ». Il a été suivi des articles « Les données dynamiques au coeur des Smart cities » et « Mobilité et données : un train de retard pour la loi LOM » avec lequel le présent article se rapproche en plusieurs points. |

Des réseaux centralisés aux Smart Grids : les données au cœur des échanges

Pour comprendre les tenants de cette évolution, rappelons d’abord quelques points clés qui permettent de comprendre en quoi la gestion des données est amenée à jouer un rôle de plus en plus important dans le secteur de l’énergie.

C’est particulièrement vrai de l’électricité avec les réseaux intelligents (Smart Grids). Deux grands ensembles sont à prendre en considération :

- L’aval compteur qui concerne directement chaque usager dans un contexte qui peut être résidentiel ou professionnel. Les questions principales touchent ici la consommation et l’efficacité énergétique. En effet, de nombreux dispositifs et services sont apparus depuis quelques années. L’énergie et surtout l’électricité sont notamment des sujets clés des bâtiments intelligents. Les initiatives sont nombreuses d’autant qu’il s’agit d’un environnement non régulé au sens des services de l’électricité.

- L’amont compteur qui couvre la chaîne de valeur critique de la production au compteur électrique. Cette chaîne distingue trois niveaux : la production, le transport qui en France relève du monopole de RTE, et enfin la distribution qui relève du régime de concessions. Celles-ci sont confiées dans 95 % des cas à Enedis. Pris dans sa globalité, cet ensemble est fortement régulé par la CRE.

Les énergies renouvelables

Les deux extrémités de la chaîne font face à une transformation profonde. D’un côté, les énergies renouvelables prennent une place de plus en plus importante dans le « mix énergétique » de la plupart des pays. Mais de l’autre, une pression de plus en plus marquée s’exerce en matière d’efficacité énergétique en agissant sur l’habitat et les usages. Ils introduisent ainsi des outils et mécanismes pour agir de manière opérationnelle en faveur d’une consommation plus vertueuse.

La contrainte consubstantielle à laquelle font face les réseaux est qu’il faut en permanence et en temps (quasi) gérer l’équilibre entre production et consommation. Les deux extrémités de la chaine étant soumis à des bouleversements, c’est l’ensemble des processus et des techniques qui s’en trouve impacté. Les réseaux intelligents ne constituent une option pour l’avenir, mais un nécessité incontournable.

1. Des énergies solaires et éoliennes intermittentes

Le passage soudain d’une production à 100 % de la capacité à 0 % crée des risques. Ceux-ci peuvent aller jusqu’au black-out comme cela s’est produit en Grande-Bretagne en 2019. Ce risque ne peut être compensé que de deux manières. La plus classique est d’assurer une gestion de la flexibilité en s’appuyant sur un volume suffisant d’énergie stable (comme en France avec le nucléaire ou en Allemagne avec le charbon). L’autre voie consiste à miser sur le stockage dont le prix tend à devenir de plus en plus compétitif.

2. Des Énergies locales décentralisées

Les énergies renouvelables sont généralement synonymes d’énergies locales décentralisées. Elles se connectent, pour la plupart, aux réseaux de distribution. Ces derniers doivent donc pouvoir fonctionner dans les deux sens. La chaîne de valeur perd sa linéarité avec la production à une extrémité et la consommation de l’autre. Les réseaux de distribution doivent ainsi fonctionner de manière bidirectionnelle. Il faut ainsi imaginer les impacts sur le traitement et la gestion des flux technique comme financiers.

3. Autoconsommation

La décentralisation des énergies renouvelables favorise les initiatives en matière de productions locales. Elles se combinent alors aux actions en faveur de l’efficacité énergétique. Cela conduit à une multiplication de projets mixant autoconsommation individuelle, autoconsommation collective et boucles énergétiques locales plus ou moins autonomes (microgrids). Dans la plupart des cas, la couverture du risque des déséquilibres électriques locaux nécessite un raccordement au réseau[1].

4. De nouveaux sujets d’étude

La diversité de la problématique de l’énergie à l’échelle locale déborde désormais sur d’autres sujets. Parmi ces sujets, le développement de la mobilité électrique et les échanges entre les différentes sources d’énergie – notamment électricité et gaz – combinés aux types d’usages (multigrids). La conversion de l’énergie renouvelable en hydrogène est un bon exemple de technologie qui intéresse les acteurs locaux. Tout d’abord pour ses vertus comme mode de stockage et aussi pour son bénéfice en termes d’émissions de CO2 par rapport à une production classique d’hydrogène.

5. Les données

Sur l’ensemble de cet éventail, on comprend que les données vont jouer un rôle particulier :

- Pour le fonctionnement de chacun des composants techniques ;

- Pour le pilotage et la gestion des flux techniques entre ces composants comme pour les échanges techniques et économiques entre les différents acteurs allant de la production jusqu’au consommateur.

Par son triple caractère technique, financier et stratégique, la donnée est amenée à occuper une place à part dans l’organisation et la gestion de l’énergie.

Le défi de l’équilibre entre décentralisation incontournable et résilience impérieuse

Les réseaux intelligents font progressivement évoluer les réseaux électriques avec des échéances différentes les réseaux de gaz. On passe d’une organisation centralisée et radiale vers une structuration en poupées russes. Au terme de cette évolution, il faut imaginer différents niveaux cherchant chacun à assurer leur autonomie. Ils renvoient également la gestion des déséquilibres résiduels à des échanges avec le niveau supérieur.

En réalité, une organisation hybride demeure. D’un côté les initiatives locales innovantes favorisent l’optimisation énergétique. De l’autre côté se consolide avec de nouveaux repères une colonne vertébrale à même d’assurer la résilience globale du réseau la garantie d’un service public accessible à tous. Le modèle hybride est donc une nécessité qui doit répondre au risque d’une archipellisation déstabilisante et dommageable.

Les données d’énergie à l’aune du déconfinement Share on XLa tendance de fond est là. Au-delà des ressources en énergies renouvelables, il nous faut faire face à une complexité croissante de la gestion des flux d’énergie et des flux financiers. La contrainte du temps réel s’impose alors même que cette réalité ne peut avoir le même sens aux différents niveaux du réseau. Un réseau de transport ne peut en effet pas s’ajuster dans les mêmes conditions que la distribution dans un immeuble. C’est tout le défi du modèle hybride avec nos poupées russes articulées. Chacune des unités doit constituer un écosystème équilibré d’un point de vue énergétique comme économique tout en apportant des garanties de performances, de fiabilité, de sécurité …

Les capteurs, les données et leur traitement vont être la clé de la gestion de ces nouveaux équilibres.

Des données de capteurs à foison de la production au compteur intelligent

Les acteurs du secteur de l’électricité n’ont pas attendu l’avènement des réseaux intelligents pour investir fortement dans l’informatique. EDF, à l’époque où l’entreprise était intégrée, bénéficiait déjà d’une forte réputation en la matière.

Les réseaux de transport face aux enjeux du renouvelable

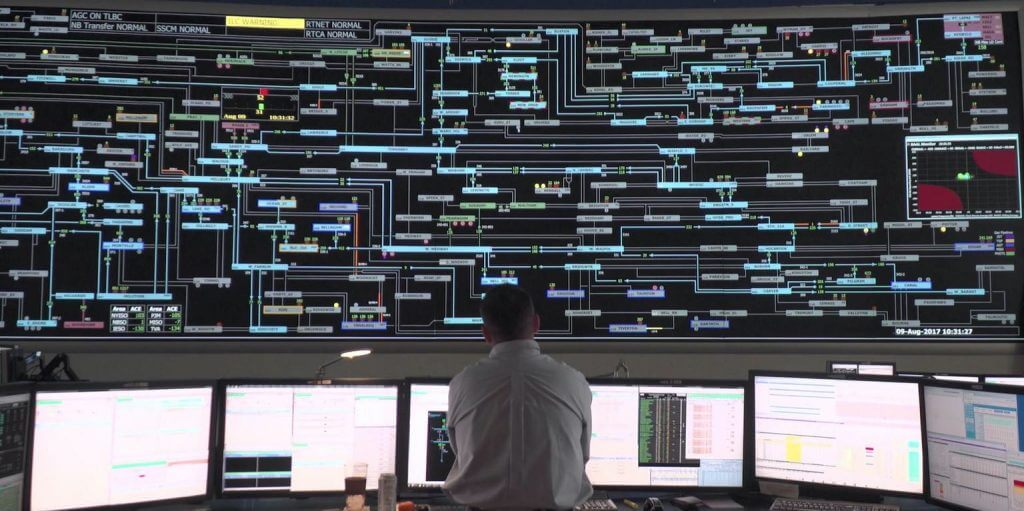

Ainsi, les projets Teleconduite2000 et ARTERE dans les années 90 et 2000 ont-ils constitué des jalons importants pour la modernisation du réseau de transport de l’électricité. Basé sur des techniques classiques et éprouvées, le traitement des données avait déjà produit bien du fil à retordre au maître d’œuvre du projet.

La décentralisation des nouvelles énergies a cependant déjà des effets sur les réseaux de transport. L’un d’entre eux concerne, par exemple, l’optimisation de la synchronisation des phases (Triphasé). En effet, plus il y a d’énergies provenant de sources différentes – et notamment de sources intermittentes – et plus les réseaux de transport doivent subir des variations plus ou moins fortes sur la synchronisation des phases.

Or les défauts de synchronisation peuvent induire des pertes de l’ordre de 10 %. C’est dommageable au plan énergétique et cela peut très vite se traduire par des pertes financières considérables. Les réseaux de transports s’équipent de synchrophaseurs (Voir l’initiative américaine dans ce domaine : North American SynchroPhasor Initiative / NASPI) ou de SCADAs (système de contrôle et d’acquisition de données) qui intègrent cette fonction.

D’autres mesures sont intégrées dans les réseaux de transport comme des automates de zone, des mesures en temps réel de la température des lignes, l’ajustement de l’ingestion d’énergie d’un parc éolien ou solaire (Dynamic Line Rating)…

Répondant une interview du Moniteur en 2017, François Brottes indiquait :

« Nous traitons 100 000 données à la seconde et bientôt, ce sera un million »

Ce chiffre correspond à 86 milliards de mesures quotidiennes. Il sera très probablement dépassé à la lumière de se connait SenX sur le monitoring de systèmes techniques pointus.

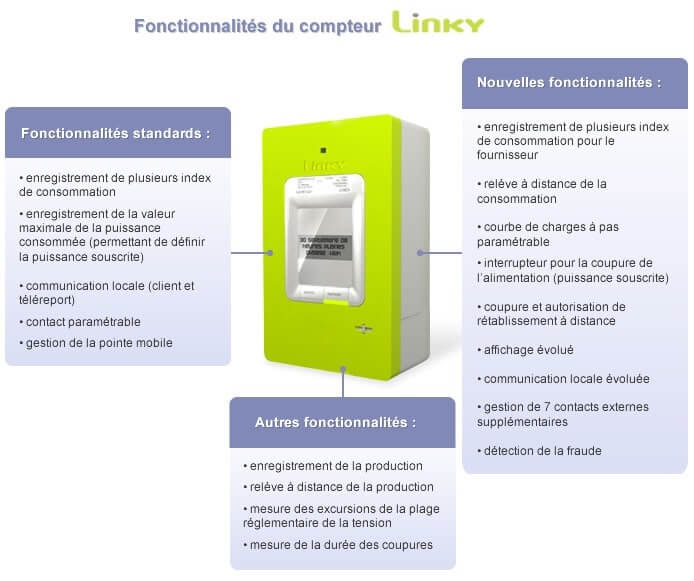

Les réseaux de distribution vers plus de services aux acteurs locaux

Pour la distribution, le sujet majeur qui s’est imposé en matière de traitement de données concerne le compteur intelligent. Avec 35 millions de compteurs, cela signifie que le système de gestion de données d’Enedis devra absorber 5 milliards de mesures par jour à raison d’une télérelève toutes les 10 minutes. Le « Système de traitement des mesures » (STM) a été conçu pour répondre au traitement de ces données. Son objectif principal à l’époque de sa conception est la gestion comptable de la consommation. Le Linky a cependant d’autres finalités comme le montre le schéma ci-dessous.

Aujourd’hui, tout l’enjeu pour Enedis consiste à devoir concilier des besoins et des contraintes différentes dans un cadre réglementaire très contraint. Enedis est en effet soumis à la réglementation du secteur de l’électricité. Mais elle doit aussi se conformer aux exigences de la CNIL pour le traitement des données privées.

| Découvrez comment analyser votre consommation électrique grâce à Linky et Warp 10. |

La production sous la pression de la décentralisation

La production dans les grandes centrales a toujours eu recours à de nombreuses mesures issues de capteurs. Ces derniers équipaient des appareillages électrotechniques avec en aval, des SCADAs et autres systèmes de contrôle commande et de détection d’alarme à l’instar de ce qui équipait la plupart des usines de production. Il n’y avait pas – ou très peu – de traitement des historiques de données de capteurs par exemple. Globalement, la culture en matière de traitement de données restait relativement faible même dans une industrie comme le nucléaire.

Ce n’est plus le cas aujourd’hui. Les centrales de production s’appuient progressivement sur des systèmes de monitoring et de contrôle commande qui intègrent du traitement de données. La maintenance prédictive qui s’appuie sur l’apprentissage de l’historique des données de capteurs trouve peu à peu sa place.

La production hydroélectrique a, pour sa part, toujours été soumise aux aléas météorologiques. Un producteur comme la Compagnie Nationale du Rhône est soumis, en tant qu’opérateur responsable d’équilibre, à des engagements contractuels qui agissent comme des pivots. Elle est pénalisée s’il produit moins que ce à quoi elle s’était engagée. Elle l’est tout autant si elle produit plus ; d’où la nécessité d’anticiper le mieux possible sa production et de jouer sur des paramètres de régulation en temps réel.

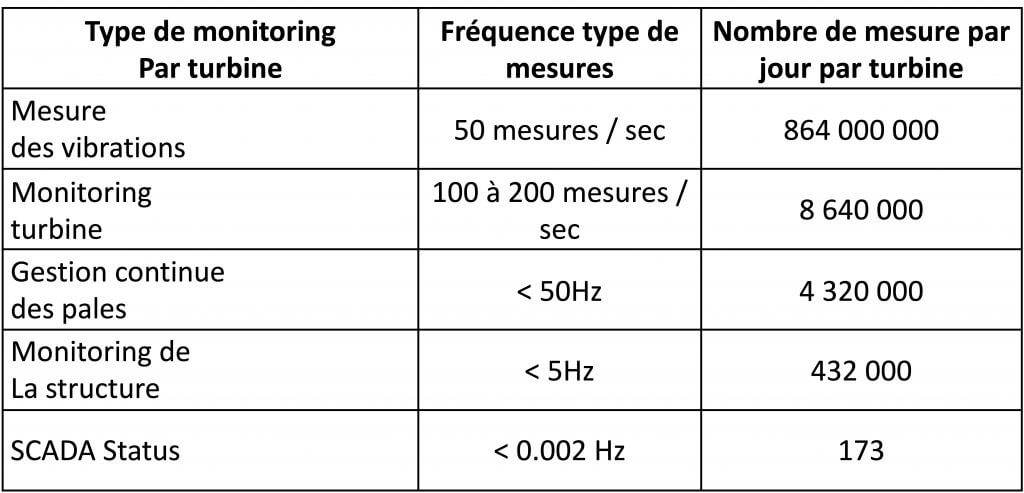

Ce sont surtout les énergies renouvelables qui font appel aux techniques de traitement de données notamment pour deux raisons :

1) la variabilité de la production nécessite une quête continue d’optimisation. Celle-ci suppose des mesures à une fréquence élevée de plusieurs composants. C’est notamment le cas pour les turbines éoliennes ou hydroliennes ainsi que progressivement, sur les fermes solaires.

2) L’intermittence induit non seulement des conséquences sur l’ingestion de l’énergie, mais a aussi des conséquences sur la rentabilité de la production dès lors que celle-ci est connectée au réseau. Il s’agit du mécanisme de pivot évoqué précédemment pour les opérateurs responsables d’équilibre.

L’aval compteur : de l’habitat à la ville et territoire intelligent

Au-delà du compteur, le marché est non régulé. Depuis quelques années, il est le lieu d’un foisonnement d’innovations dont la dimension numérique est le point commun. L’Internet des Objets focalise à lui seul une grande part de ces innovations avec une préoccupation récurrente pour la maîtrise de la consommation énergétique.

Cette nouvelle instrumentation en matière de performance énergétique s’applique naturellement aux nouveaux immeubles. Elle peut également s’appliquer à des bâtiments anciens dont la rénovation n’est pas toujours possible.

Touchant l’habitat individuel et collectif comme les immeubles à vocation professionnelle, cette évolution s’accompagne d’une production de données conséquente. Comme le décrit cet intéressant papier de Wavestone, le bâtiment entre dans l’ère du digital.

Le GIMELEC et la Smart Building Alliance (SBA) relayent à leur niveau le potentiel et l’intérêt du bâtiment connecté et du traitement de données.

Au-delà de l’habitat et des immeubles, ces questions rebondissent au niveau des quartiers et plus globalement des collectivités. De fait, elles ne concernent plus simplement la consommation. Elles rebouclent sur des problématiques de réseaux intelligents avec en perspective, une optimisation jouant sur la production et la consommation à l’échelle locale dans un univers connecté électriquement et numériquement.

C’est notamment l’ambition des programmes de déploiement des réseaux intelligents à grande échelle que sont SMILE en Bretagne et Pays de la Loire et Flexgrid en Région Sud. Plus globalement la plupart des régions portent des initiatives dans ce domaine tout comme un certain nombre de syndicats départementaux.

La gestion de la complexité

Il ressort de ce panorama le sentiment d’une grande richesse de projets, mais aussi une grande complexité.

Des projets qui se développent chacun de leur côté

Les projets Smart Grids sont tous innovants sur différentes thématiques. Elles peuvent agir de manière vertueuse sur la chaîne de valeur allant de la production à la consommation comme s’en fait régulièrement écho l’association Think Smart Grids.

Mais, à ce stade, hormis la modernisation du cœur des systèmes des gestionnaires de réseaux, chaque projet reste porté par construction par ses propres objectifs et s’appuie sur un budget qui lui est propre. De plus, chacun d’entre eux est mené par un consortium spécifique. Il est généralement constitué de partenaires industriels, acteurs publics, associations et laboratoire de recherche.

Et pour clôturer le tout, chaque projet développe sa plateforme de données. Pour des raisons techniques comme stratégiques qu’on peut très bien comprendre, chaque consortium entend conserver la maîtrise de sa propre plateforme en évitant les interférences externes. Conclusion : on est encore loin d’un déploiement à grande échelle.

Mais…

Pourtant, il ne fait pas de doute que les projets de déploiement devront progressivement tisser des liens et jouer à l’échelle locale, départementale et régionale sur la gestion de nouveaux équilibres. C’est le modèle de nos poupées russes qui a vocation à devenir progressivement une réalité.

L’intelligence artificielle occupera une place de choix dans cette évolution. Non pour ajouter de la complexité à la complexité comme cela peut sembler, mais au contraire, pour la masquer par des mécanismes d’apprentissage et d’adaptation à l’environnement et aux besoins.

C’est tout l’enjeu de la nécessaire évolution du traitement de données. Partit du simple traitement unitaire des données issues de chacun des capteurs pris de manière individuelle, le traitement des données doit aller jusqu’à des systèmes dont la complexité est assistée par de l’intelligence artificielle.

Les systèmes classiques dans l’énergie et dans l’industrie en général remontent les données de capteurs dans des SCADAs. Les niveaux 1 et 2 du schéma qui précède sont très bien couverts dans les réseaux énergétiques.

Ensuite pour le niveau 3, c’est l’objet des travaux menés par les opérateurs de réseaux et par les acteurs des réseaux intelligents dans un contexte rappelé précédemment. La plupart de ces systèmes ne sont cependant pas adaptés à un déploiement à grande échelle et à une évolution vers le niveau 4 des Smart Grids interconnectés.

Il ne s’agit pas d’un schéma théorique, mais d’une évolution vers la mise en œuvre de mécanismes techniques et financiers de gestion d’optimisation de la flexibilité à une grande échelle. Si on prend le cas des Régions qui participent au financement de projet Smart Grids, c’est une perspective qui a vocation à s’imposer naturellement. Encore sera-t-il nécessaire d’être en capacité de jouer sur l’intermédiation entre les systèmes et les acteurs.

Organisation classique des données et séries temporelles

Dans les systèmes informatiques classiques, les données sont structurées en fonction de contingences métiers. Elles disposent de formats spécifiques à chaque environnement, à chaque acteur…

Ce mode d’organisation des données est historiquement le plus répandu. Il est également le plus maîtrisé par les grands acteurs, les industriels et les sociétés de services. Les techniques qui s’y rapportent sous-tendent donc la plupart des projets menés dans l’énergie en général et les réseaux intelligents en particulier. Cependant, ce type d’approche fait face à des problèmes de performances et d’interopérabilité. Il faut en effet des formats sémantiques communs de référence.

Les données de capteurs sont elles, particulières. Tant que le nombre de sources de données reste limité ou que les volumes restent faibles, on peut s’accommoder de techniques classiques. Mais très vite se posent des problèmes liés notamment à la diversité des comportements des capteurs, de leur nombre et des volumes de données générés.

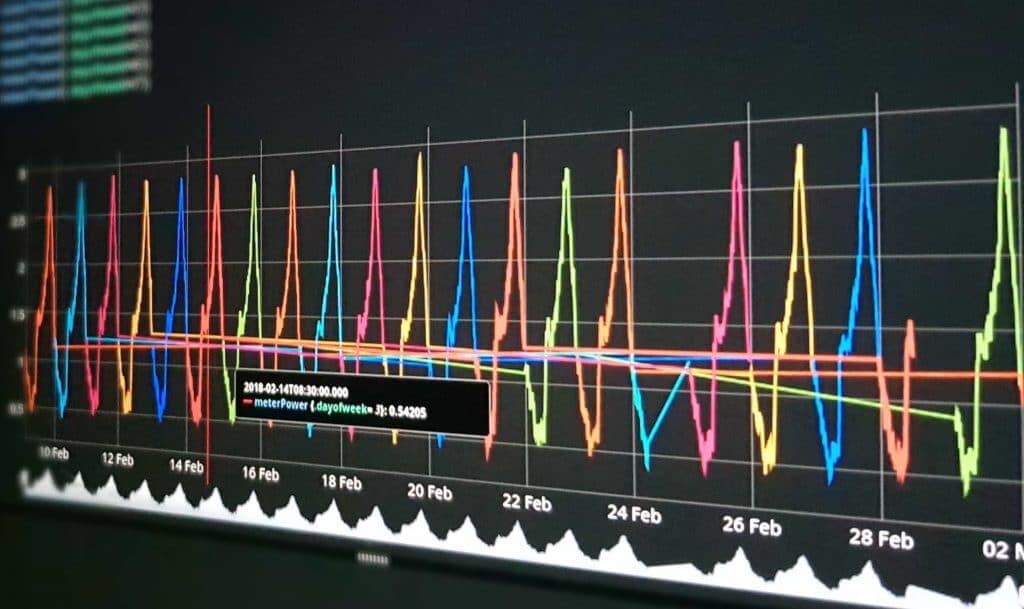

Avec une organisation des données basée sur les séries temporelles (Time Series), les données sont stockées, organisées et traitées à partir d’une clé d’entrée. C’est la plus importante dès lors qu’on fait des mesures séquencées : le temps. Les techniques Time Series sont, par ailleurs, bien plus puissantes (jusqu’à un facteur pouvant dépasser le millier) pour les données de capteurs et autres mesures.

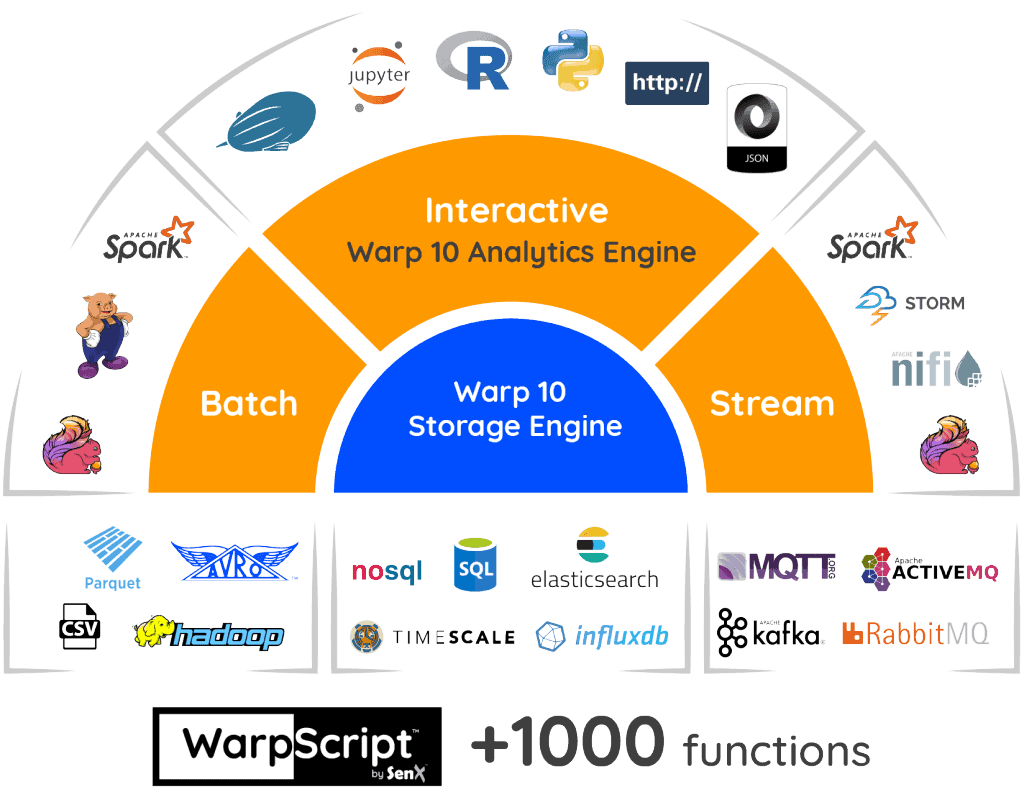

Warp 10

Warp 10 est la solution Open Source développée par SenX. Elle a été précisément créée pour répondre aux enjeux que sont :

- Les performances,

- L’interopérabilité (qui n’est pas du tout abordée de la même manière dans les technologies classiques),

- La neutralité (en étant totalement indépendant des applications métiers),

- Enfin, la sécurité des données comme conséquence « augmentée » de cette même indépendance.

C’est notamment le sens de l’engagement de SenX dans la plateforme PRIDE développée au titre du programme SMILE dans les régions Bretagne et Pays de la Loire.

Quid de l’Intelligence Artificielle ?

L’intelligence artificielle (IA) est un prolongement naturel de ce mode d’organisation des données. L’IA la plus répandue dans la sphère médiatique est basée sur un apprentissage spatial : savoir reconnaître un chien, une table, une voiture, un visage sur une image ou une vidéo. Dans l’industrie ou l’énergie, il s’agit d’un apprentissage temporel à partir de données de capteurs. Il s’agit de comprendre avec une suite de multiples mesures comment fonctionne une machine, un système, un flux d’énergie…

Les technologies de séries temporelles facilitent ces développements sur la base d’un accès à l’historique des données. Sans collecte passée d’un tel historique, vouloir développer des services basés sur l’intelligence artificielle est voué à l’échec.

D’où un paradoxe classique pour un certain nombre d’acteurs dont les collectivités entre

- Collecter des données dès lors qu’elles ont défini des cas d’usages

- Développer des services qui nécessitent l’accès à un historique de données… qu’elles n’ont pas constitué.

La place des grands acteurs du numérique

Dans l’univers du Big Data et de Warp 10, le traitement et le stockage historisés de 1 million de mesures par seconde n’est absolument pas démesuré comparé au nombre de mesures collectées par un avion ou pour le monitoring d’un data center. On est aussi très loin de la capacité des acteurs du numérique comme Google ou Amazon.

Google a fait quelques allers-retours dans l’énergie sans avoir de stratégie totalement lisible. Mais dans nos échanges, ils ont toujours marqué un grand intérêt pour ce secteur, ne serait-ce que pour leurs besoins internes.

Le géant américain a récemment expliqué comment il entendait atteindre le 100 % d’énergies renouvelables pour sa propre consommation. Autre initiative, le projet Sunroof qui entend cartographier à l’échelle globale l’ensemble de potentiel de production solaire. Mais, à l’inverse de la mobilité, on ne peut pas dire que Google soit « sorti du bois » pour affirmer une stratégie globale.

En l’état, le marché des plateformes dans l’énergie reste dominé par des acteurs spécialisés tels Schneider Electric, Siemens, ABB ou encore de General Electric. Ce dernier avait, il y a quelques années, lancé la plateforme PREDIX qui devait révolutionner l’industrie. Avec la réorganisation de GE, Predix a disparu et le groupe a repris une stratégie plus ciblée sur son cœur de métier.

Et en France ?

En France, Engie a également beaucoup communiqué sur ce sujet à l’époque d’Isabelle Kocher. En 2016, l’entreprise passe un accord stratégique avec l’Américain C3.IoT (devenu C3.ai pour la bonne cause). Elle revient alors à des réalités plus concrètes. Le rachat de SIRADEL spécialisé dans la représentation 3D de données dans le contexte des Smart Cities a marqué un tournant ponctué de succès notamment Ile-de-France, à Angers… Il reste encore à faire le lien avec une véritable plateforme globale sur l’énergie, un objectif pour le groupe.

Des entreprises comme Vinci, Eiffage, Bouygues et également EDF (avec Dalkia et Citelum) souhaitent, elles aussi, affirmer leur place. Cependant hormis EDF, toutes privilégient un mode d’organisation très décentralisé pas toujours compatible avec l’affirmation d’une solution unique.

À ce jour, ce marché reste encore très éparpillé et les solutions très silotées. Chacun propose sa solution verticale de plateforme et entend que celle-ci favorise le développement de nouveaux services qui s’appuieront de manière privilégiée sur elle. Les problématiques parfois insondables de l’interopérabilité jouent en ce sens.

Le service public de la donnée et le risque/bénéfice du partage

La FNCCR regroupe les syndicats d’électricités, tout comme un certain nombre de collectivités. Ceux-ci militent pour un service public de la donnée.

Pour beaucoup, un tel service est associé à une plateforme d’ouverture des données. D’aucuns militent pour que ce soit le cas. Force est de constater qu’il y un nombre croissant de données ouvertes dans le secteur de l’énergie. C’est une évolution très positive comme le montre le travail dans ce domaine d’OpenDataSoft. Pour autant, un véritable fonctionnement des réseaux intelligents et des échanges de données qu’ils impliquent nécessitera des croisements de données qui ne seront pas nécessairement ouvertes.

Quatre raisons peuvent être mises en avant

- Pour des raisons de sécurité, de protection de la vie privée, de protection de données protégée par des droits connexes etc, les données ouvertes resteront nécessairement limitées. Certes, les acteurs sont conduits à publier des données. Celles-ci ne seront cependant pas les données brutes temps réel dont les acteurs de la chaîne de valeur auront besoin.

- Une stratégie basée uniquement sur les données ouvertes conduit les acteurs à se tromper de débat. La question n’est pas de savoir comment on ouvre les données et comment on passe son temps à limiter cette ouverture. Elle est plutôt de savoir comment il va être possible de croiser des données brutes d’acteurs différents et, le cas échéant concurrents, de manière protégée et sécurisée sans qu’ils aient pour cela besoin d’accéder aux données brutes elles-mêmes.

- La limitation du débat aux données ouvertes n’encourage pas les collectivités – et leurs fournisseurs – à franchir le saut technologique du Big Data. Elles confient souvent l’ouverture des données à un tiers alors que le territoire intelligent de demain va générer des données brutes en très grands volumes au cœur de leurs propres services.

- Les grands acteurs des plateformes de l’énergie seront en capacité de mieux tirer profit des données ouvertes. Elles leur permettront d’affiner leurs propres données. Ce faisant, ils risquent de mettre à mal toute nouvelle valeur que des acteurs alternatifs pourraient vouloir créer.

Le traitement des données

Beaucoup de collectivités, tout comme l’État, ont été sensibilisées positivement à la question de la gouvernance des données. Cependant, ce débat élude la prise de conscience nécessaire des enjeux technologiques. Ils apparaissent comme totalement secondaires parce que perçus comme un non-problème.

Or le passage à l’échelle fait apparaître de nombreuses contraintes et oblige notamment à automatiser des traitements. Ainsi, en mode opérationnel, on ne transmet pas les données à un data scientist qui renvoie les résultats quelques heures après. L’analyse et l’interprétation des résultats doivent être intégrées dans des processus automatiques.

Ces contraintes paraissent des évidences, mais elles imposent de maîtriser certaines techniques et outils. Ceux-ci relèvent non pas de la science de la donnée (Data Science), mais de l’ingénierie de la donnée (Data Engineering). Les deux niveaux s’opposent encore trop souvent. Les « Data Scientists » n’ont souvent que faire des contraintes techniques qu’entendent traiter les « Data Engineers ».

… avec Warp 10

Avec Warp 10, SenX œuvre à promouvoir la création d’infrastructures de données neutres. Cet objectif est poursuivi sans prétention aucune en matière de création de services dans le secteur de l’énergie. Une telle option ne consiste pas à simplement agréger des données et à en donner l’accès à quiconque.

Elle met des outils de gouvernance des données dans les mains des acteurs sans préjuger des règles qu’ils définiront. Elle donne également la possibilité de croiser des sources de données variées, hétérogènes, nombreuses. Un acteur pourra alors avoir accès, selon ses droits, à des données en temps réels, ou agrégées à l’heure ou la journée, ou encore selon un périmètre géographique, ou résultant d’un traitement… Toute cette souplesse repose sur des mécanismes et outils de traitement de séries temporelles. Les données dans l’énergie sont précisément pour la plupart des séries temporelles.

Pour terminer, nous aborderons dans un prochain article, la relation nouvelle que cette évolution va induire entre les opérateurs et les collectivités territoriales. Celle-ci va changer de nature. Le Big Data et l’Intelligence Artificielle vont en être le moteur d’une transformation dont on ne perçoit encore que les prémisses.

Contactez SenX pour savoir comment Warp 10 peut vous aider à traiter et analyser vos données d’énergie.

[1] Une telle évolution pose des questions stratégiques aux acteurs traditionnels du marché. Elle en pose par voie de conséquence, aux collectivités et syndicats qui gèrent les infrastructures, au régulateur qui défini les règles et à l’État qui doit assumer les arbitrages politiques. Le présent article s’arrête à un constat et ne porte pas d’avis sur ces conséquences.

Read more

May 2020: Warp 10 release 2.6.0

Industrie du futur : les données sur le chemin critique - Partie 1

OVH, encore un effort si vous voulez être crédibles

Co-Founder & former CEO of SenX